A estatística descritiva e tomada de decisão constitui a base analítica de qualquer processo corporativo que dependa de dados para compreender variabilidade, diagnosticar comportamentos, antecipar riscos e estruturar decisões operacionais e estratégicas. Sua aplicação ultrapassa cálculos isolados e envolve interpretação detalhada, organização sistemática e contextualização dos dados dentro de processos industriais, logísticos, administrativos e de qualidade. A profundidade desses conceitos é essencial para transformar informações dispersas em análises consistentes, capazes de orientar ações, corrigir desvios, otimizar processos e sustentar estratégias de longo prazo.

A relevância da estatística descritiva está na capacidade de revelar padrões, identificar tendências, expor variações e construir visão estruturada sobre o desempenho real de um sistema. Processos industriais, rotinas de supply chain, gestão da qualidade e operações corporativas dependem desse nível de entendimento para interpretar comportamentos, identificar fontes de instabilidade e fortalecer governança. A precisão da análise estatística orienta decisões que influenciam produtividade, eficiência, confiabilidade e segurança operacional.

A estatística descritiva representa o primeiro nível de investigação científica e operacional dentro das organizações. A compreensão da variabilidade é elemento central para qualquer tomada de decisão baseada em dados, pois toda operação real apresenta dispersão e comportamento não uniforme. A análise da variabilidade permite interpretar estabilidade, desempenho e consistência de processos, revelando comportamentos que influenciam diretamente produtividade, custos e qualidade.

A variabilidade é um fenômeno natural. Temperaturas oscilam, tempos de ciclo variam, pesos de produtos apresentam diferenças mínimas, estoques sofrem flutuações e indicadores financeiros refletem movimentos do mercado. A estatística descritiva permite quantificar essa variabilidade e entender se ela resulta de causas comuns inerentes ao processo ou de causas especiais que indicam falhas estruturais. Esse entendimento orienta ajustes, intervenções e melhorias.

A análise correta da variabilidade evita decisões precipitadas e interpretações equivocadas. Alterações pontuais podem gerar conclusões inadequadas quando avaliadas sem ferramentas estatísticas adequadas. A estatística descritiva oferece linguagem consistente para interpretar amplitudes, dispersões e tendências, criando base sólida para análises avançadas de desempenho.

Dados brutos não possuem significado sem contextualização. A estatística descritiva organiza informações dispersas, formando estrutura clara que permite enxergar comportamentos reais. A tabulação correta, a classificação adequada e a representação visual estruturada transformam dados não interpretáveis em elementos que orientam decisões. A interpretação sólida depende da combinação entre organização, leitura matemática e compreensão do processo.

Essa transformação permite que gestores, analistas e especialistas entendam fenômenos de forma objetiva. A informação estruturada sustenta modelos de priorização, classificação de problemas e avaliação contínua de estabilidade.

A classificação dos dados é o ponto de partida para qualquer estudo descritivo. Cada tipo de dado exige tratamento específico, determina modelos de cálculo e influencia forma de tabulação e interpretação. A correta identificação dos tipos de dados determina qualidade da análise e previne erros que podem comprometer toda a conclusão estatística.

Dados qualitativos representam atributos, características ou classificações que não podem ser expressas numericamente de maneira direta. Eles ajudam a segmentar eventos, descrever comportamentos e classificar ocorrências.

Dados nominais não possuem hierarquia. Exemplos incluem tipos de defeitos, cores de produtos, categorias de fornecedores e departamentos.

Dados ordinais possuem ordem, como níveis de severidade, ratings de satisfação, classificações de prioridade ou faixas de desempenho. A análise desses dados requer atenção ao fato de que a distância entre categorias não é necessariamente uniforme.

O tratamento inadequado de dados qualitativos pode gerar conclusões distorcidas quando aplicadas técnicas que assumem continuidade ou proporcionalidade numérica.

Dados quantitativos representam valores numéricos e permitem operações matemáticas completas. Eles se dividem em discretos e contínuos. Dados discretos derivam de contagens e só assumem valores inteiros. Exemplos incluem número de defeitos, quantidade de itens produzidos e ocorrências de falhas.

Dados contínuos podem assumir qualquer valor dentro de um intervalo e representam medições físicas ou temporais, como peso, volume, tempo de ciclo, temperatura e dimensões.

A análise correta depende de identificar se o dado é discreto ou contínuo, pois isso influencia cálculos de frequência, histogramas, medidas de dispersão e testes de comportamento.

A classificação determina o conjunto de ferramentas disponíveis e adequadas. Gráficos de barras são apropriados para dados qualitativos, enquanto histogramas se aplicam a dados contínuos. A mediana e a moda são preferenciais em casos de dados assimétricos ou amostras distorcidas. A média é útil em distribuições simétricas. A correta identificação dos dados previne erros de interpretação e garante que conclusões se baseiem em fundamentos estatísticos sólidos.

A coleta adequada define qualidade da análise. Processos industriais e corporativos exigem precisão na definição de amostragem, metodologia e frequência. A ausência de critérios estruturados compromete análises, reduz confiabilidade e aumenta riscos de interpretações equivocadas.

A representatividade da amostra é elemento crítico para garantir que conclusão estatística reflita realidade operacional. Amostras enviesadas produzem análises distorcidas e decisões equivocadas. Em operações industriais, a coleta deve refletir variações naturais do processo, períodos de maior demanda, mudanças ambientais e fontes de instabilidade.

A escolha da metodologia de coleta determina robustez da análise. Coletas contínuas fornecem visão detalhada do comportamento temporal. Coletas sistemáticas permitem identificar padrões. Coletas aleatórias reduzem viés humano.

A organização estruturada dos dados facilita cálculo, interpretação e transporte das informações entre ferramentas. A tabulação clara exige definição de variáveis, identificação de unidades, padronização de nomenclaturas e construção de bancos coerentes. Em ambientes industriais, organização indevida pode distorcer valores, prejudicar análises de capabilidade e impactar decisões operacionais.

A tabulação é etapa intermediária entre coleta e análise. Tabelas estruturadas permitem identificar valores críticos, outliers, tendências e agrupamentos. Essa preparação facilita criação de gráficos, cálculos de medidas de posição e dispersão, além de fortalecer confiabilidade das interpretações subsequentes.

As medidas de posição representam o núcleo da estatística descritiva e permitem compreender o comportamento central dos dados. A tendência central é elemento fundamental para avaliar estabilidade, identificar desvios e monitorar consistência dos processos. A interpretação correta dessas medidas permite evitar conclusões equivocadas e utilizar os indicadores adequados em cada situação.

A média representa o valor central calculado pela soma dos valores dividida pelo número de observações. Sua utilidade é evidente em processos estáveis e com distribuição simétrica. Em sistemas industriais, a média auxilia avaliação de produtividade, desempenho, consumo energético e tempos de ciclo.

Entretanto, a média é sensível a valores extremos. Outliers deslocam a tendência e podem sugerir comportamento que não representa operação real. A interpretação inadequada pode levar a conclusões incorretas e intervenções desnecessárias. A análise deve considerar características do processo antes de adotar a média como indicador central.

A mediana representa o ponto central da distribuição quando os dados são ordenados. Ela é robusta e pouco sensível a valores extremos. Em processos com assimetria, variações abruptas ou dados com presença de valores anômalos, a mediana oferece representação mais fiel do comportamento real.

Em ambientes operacionais, a mediana é útil para avaliar tempos de entrega, tempo de resposta, tempos de ciclo com variabilidade elevada e processos que apresentam irregularidades. Sua aplicação reduz distorções e permite decisões mais precisas.

A moda representa o valor mais frequente da amostra. Ela é utilizada em dados qualitativos e quantitativos discretos. Em ambientes industriais, auxilia identificação de ocorrências repetitivas, padrões de defeitos, comportamentos predominantes e categorias mais incidentes.

A interpretação da moda revela comportamentos dominantes, mas não substitui medidas de tendência central em análises contínuas. Sua utilidade está em complementar análises e identificar padrões operacionais.

A análise da dispersão é elemento essencial para compreender variabilidade. Medidas de dispersão revelam nível de estabilidade, consistência e previsibilidade. A interpretação dessas medidas orienta decisões técnicas e permite identificar controles necessários para reduzir riscos operacionais.

A amplitude representa diferença entre maior e menor valor da amostra. É simples e fornece visão inicial da variabilidade. Entretanto, sua sensibilidade a valores extremos limita interpretação isolada. Em operações industriais, amplitude auxilia análise inicial, mas não representa estabilidade real do processo.

A variância representa média dos desvios elevados ao quadrado. Ela quantifica dispersão e indica quanto os valores se afastam do centro. A variância serve como base para cálculo do desvio padrão e é utilizada em análises profundas de estabilidade, estudos de capabilidade e avaliações estatísticas avançadas.

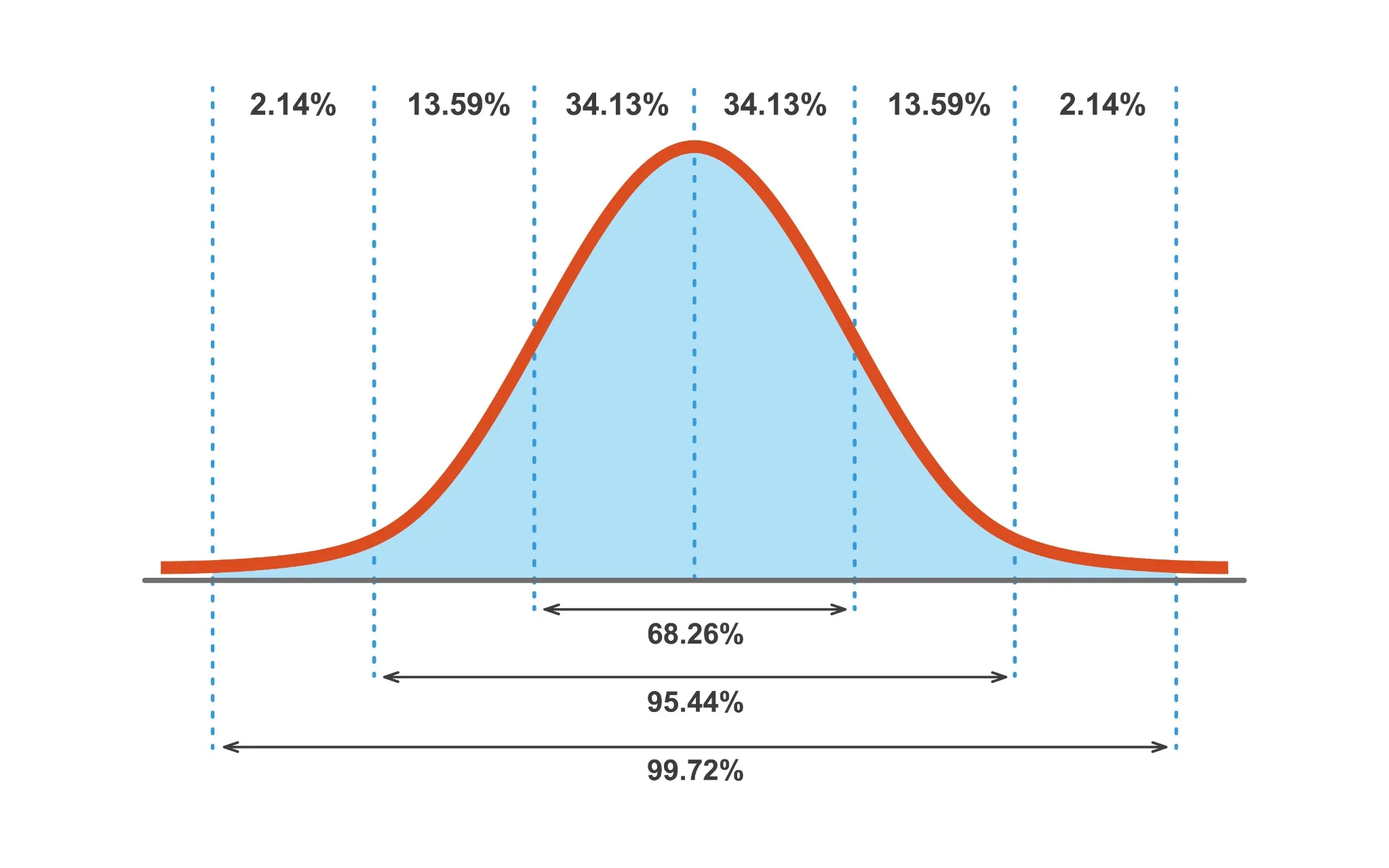

O desvio padrão indica o afastamento médio em relação à média e é a principal medida de dispersão utilizada em processos industriais. Ele permite avaliar estabilidade, comparar desempenho entre períodos e identificar descontinuidades. Em análises corporativas, o desvio padrão orienta decisões sobre confiabilidade, previsibilidade e risco operacional.

O coeficiente de variação representa relação entre desvio padrão e média. Ele permite comparar variabilidade entre processos diferentes e entre períodos distintos. Em ambientes industriais, essa medida auxilia avaliação de consistência e identificação de processos instáveis. Valores elevados indicam necessidade de intervenção e ajustes estruturais.

As medidas de forma ampliam a capacidade de interpretação da estatística descritiva ao revelar características profundas da distribuição dos dados. Elas permitem identificar padrões de comportamento, detectar assimetrias, avaliar colas e antecipar riscos relacionados a interpretações equivocadas. Esses elementos são fundamentais para processos industriais, controle estatístico, análises logísticas e estudos de produtividade que dependem de estabilidade e previsibilidade. A forma da distribuição influencia diretamente a escolha de ferramentas estatísticas, a utilização de modelos de previsão e a interpretação do comportamento real do processo.

A assimetria representa o grau de inclinação da distribuição e revela se os dados estão concentrados mais à direita ou à esquerda. Em distribuições industriais, a presença de assimetria indica que o processo possui tendência a valores mais altos ou mais baixos, impactando decisões de controle e ajustes de operação.

Assimetria positiva representa cauda alongada à direita, indicando presença de valores altos mais distantes do centro. Em operações logísticas, esse comportamento ocorre em tempos de entrega quando existem poucas ocorrências extremamente longas. Assimetria negativa representa cauda à esquerda, caracterizando valores muito baixos que puxam a distribuição. Em análises de consumo energético, eventos de baixíssimo consumo podem gerar assimetria negativa.

Compreender a assimetria permite identificar fontes de instabilidade e adotar intervenções específicas. Processos assimétricos dificultam análises que dependem de normalidade, influenciando decisões de capabilidade, controle e limites.

A curtose representa o grau de concentração dos dados em torno da média e revela se a distribuição possui picos acentuados ou colas alongadas. Distribuições com curtose elevada apresentam muitos valores próximos do centro e colas mais carregadas, indicando aumento do risco de valores extremos. Esse comportamento é crítico em análises industriais, processos de alta precisão e rotinas com tolerâncias estreitas.

Curtose baixa indica distribuição mais achatada, com valores mais dispersos ao longo da faixa. Esse padrão ocorre em sistemas com grande variabilidade e menor concentração de valores centrais, dificultando previsibilidade.

A interpretação correta da curtose auxilia decisões sobre limites de controle, avaliação de tendências e análise de confiabilidade. Em ambientes corporativos, distribuições com curtose elevada podem indicar processos aparentemente estáveis, mas com risco elevado de eventos raros e extremos que influenciam diretamente a tomada de decisão.

A representação gráfica é ferramenta essencial para interpretar padrões que não são perceptíveis apenas por cálculos numéricos. Histogramas, curvas de densidade e distribuições de frequência permitem visualizar comportamento, identificar agrupamentos, detectar valores anômalos e avaliar estabilidade de processos. Em ambientes industriais e logísticos, gráficos têm papel determinante na tomada de decisão operacional, pois revelam comportamentos que influenciam diretamente produtividade, qualidade e desempenho.

A distribuição de frequência organiza dados em intervalos, revelando como valores se concentram ao longo da faixa observada. Em análises industriais, essa representação mostra dispersão, tendência e comportamento geral do processo. Distribuições bem definidas auxiliam análise de consistência, identificando eventos repetitivos e variações significativas.

A escolha adequada dos intervalos é fundamental para evitar interpretações equivocadas. Intervalos muito largos ocultam padrões importantes, enquanto intervalos muito estreitos exageram a variabilidade e dificultam compreensão. O equilíbrio garante leitura objetiva e interpretação confiável.

Histogramas representam visualmente a distribuição de frequência, permitindo identificar forma, amplitude, dispersão e padrões associados ao comportamento do processo. Eles são amplamente utilizados em análises de qualidade, logística, manutenção e operações industriais pela sua capacidade de evidenciar tendências que não aparecem em métricas isoladas.

Um histograma bem construído revela presença de múltiplos picos, indicando variabilidade estrutural ou influência de diferentes causas. Ele permite identificar processos bimodais, padrões sazonais, comportamentos anômalos e desvios significativos. Em processos de manufatura, histogramas evidenciam problemas de calibração, desgaste de equipamentos e mudanças não controladas.

Além dos histogramas, outros gráficos complementam a análise descritiva. O boxplot revela mediana, quartis, amplitude e valores discrepantes de forma direta e eficiente. Ele permite comparar processos, avaliar impacto de intervenções e identificar outliers que influenciam variabilidade.

As curvas de tendência mostram evolução ao longo do tempo, essenciais para análises logísticas e operacionais. Elas evidenciam períodos de instabilidade, sazonalidades e variações que impactam decisões estratégicas.

Os gráficos de dispersão mostram relação entre duas variáveis, permitindo visualizar padrões, correlações e comportamentos alinhados ou divergentes. Eles são fundamentais para identificar fatores de influência, auxiliar diagnósticos e suportar análises estatísticas avançadas.

A variabilidade é elemento central para decisões industriais, logísticas e corporativas. A interpretação correta da variabilidade orienta ações que influenciam custos, produtividade, estabilidade, capabilidade e previsibilidade. Análises descritivas bem estruturadas revelam se o processo opera sob condições normais ou se apresenta sinais de instabilidade que exigem intervenção imediata.

A análise estatística permite identificar se flutuações derivam de causas comuns ou causas especiais. Causas comuns representam variabilidade natural do processo e não exigem intervenções imediatas, mas orientam revisões de longo prazo. Causas especiais representam anomalias, indicando presença de falhas, eventos inesperados ou fontes externas de perturbação.

O reconhecimento correto dessas causas evita intervenções inadequadas. Ajustes desnecessários em processos estáveis aumentam variabilidade e comprometem produtividade. Em contrapartida, ignorar causas especiais produz falhas contínuas e perdas operacionais.

Indicadores operacionais refletem comportamento do processo ao longo do tempo. A variabilidade influencia diretamente KPIs industriais, logísticos e administrativos. Altos níveis de variabilidade dificultam previsibilidade, reduzem produtividade e aumentam custos. Análises descritivas permitem identificar quais etapas apresentam maior instabilidade e onde intervenções são necessárias.

A redução da variabilidade melhora qualidade, fortalece confiabilidade e facilita previsão. Processos com baixa dispersão operam com maior consistência, reduzindo desperdícios, retrabalhos e paradas não programadas.

A conexão entre variabilidade e capabilidade é fundamental para avaliar desempenho do processo em relação às especificações definidas. A estatística descritiva fornece informações necessárias para calcular índices de capabilidade, como Cp e Cpk, permitindo avaliar se o processo atende aos requisitos.

A análise de controle estatístico de processo depende diretamente da interpretação da variabilidade. Gráficos de controle mostram comportamento temporal, evidenciando instabilidade, eventos anômalos e mudanças estruturais.

A estatística descritiva oferece base para metodologias estruturadas de melhoria, controle e gestão analítica. Ela sustenta fases do DMAIC, orienta análises de causa raiz e apoia decisões sustentadas por evidências. A profundidade da análise descritiva aumenta precisão, reduz erros de diagnóstico e fortalece governança.

Na etapa Definir, a estatística descritiva ajuda a identificar variações críticas e quantificar impacto. Na etapa Medir, ela fornece métodos para organizar dados, definir amostragem e criar representações objetivas. Na etapa Analisar, permite identificar causas estruturais, avaliar dispersões e identificar comportamentos anômalos. Nas etapas Melhorar e Controlar, orienta monitoramento e validação dos resultados.

O controle estatístico de processo depende da interpretação de medidas descritivas e da leitura adequada da variabilidade. Gráficos de controle, limites calculados e análises de estabilidade utilizam diretamente média, desvio padrão e medidas de posição. A profundidade da análise descritiva reduz risco de intervenções equivocadas e fortalece credibilidade das decisões.

Processos logísticos operam sob alta variabilidade. A interpretação correta dos dados permite prever prazos, antecipar falhas e estruturar modelos de abastecimento. A estatística descritiva ajuda a modelar comportamento da demanda, identificar padrões sazonais e construir previsões mais precisas.

A análise de dispersão revela necessidade de estoques de segurança, modelos de reposição e estratégias de mitigação. A interpretação adequada dos dados reduz rupturas, diminui custos e aumenta previsibilidade do fluxo logístico.

A aplicação inadequada da estatística descritiva compromete decisões e gera riscos operacionais. Alguns erros são recorrentes em ambientes industriais e corporativos, podendo distorcer análises e levar a intervenções equivocadas.

A média perde representatividade em distribuições assimétricas. Utilizá-la como indicador central em processos com outliers ou dados distorcidos produz conclusões incorretas e reduz precisão da análise.

A interpretação equivocada de causas comuns e especiais leva a decisões inadequadas. Ajustes em processos estáveis aumentam variabilidade, enquanto ignorar causas especiais prolonga instabilidade.

Intervalos mal definidos distorcem percepção da variabilidade. Isso pode ocultar padrões críticos ou sugerir comportamentos inexistentes, comprometendo decisões operacionais e estratégicas.

A estatística descritiva orienta decisões por meio da análise rigorosa da variabilidade, identificação de padrões e compreensão profunda do comportamento dos dados. A tomada de decisão estruturada depende de interpretação sólida, precisão na coleta, organização eficiente e contextualização técnica das informações.

A fundamentação estatística fortalece decisões operacionais e estratégicas. Dados bem interpretados revelam padrões e orientam priorização de ações, possibilitando direcionamento eficiente de recursos e sustentação de indicadores críticos.

A estatística descritiva reduz incerteza ao explicitar comportamento real do processo. A leitura correta das medidas reduz riscos, orienta planos de ação e fortalece governança.

A estatística descritiva representa a base de qualquer análise quantitativa aplicada a ambientes industriais, corporativos e logísticos. Sua profundidade permite identificar tendências, quantificar variabilidade, reduzir incertezas e transformar dados brutos em informação estruturada. A aplicação correta dessas ferramentas sustenta decisões operacionais e estratégicas, fortalece rotinas de melhoria contínua, orienta modelos de previsão e amplia consistência dos processos.

O domínio dessas técnicas possibilita interpretações mais precisas, identificação de causas estruturais e melhoria da estabilidade operacional. A estatística descritiva conecta conceitos matemáticos ao comportamento real dos processos, sustentando decisões sólidas e orientadas por evidências. Esse nível de análise garante maior previsibilidade, controle e eficiência, permitindo que organizações enfrentem desafios complexos com disciplina técnica e visão estruturada.